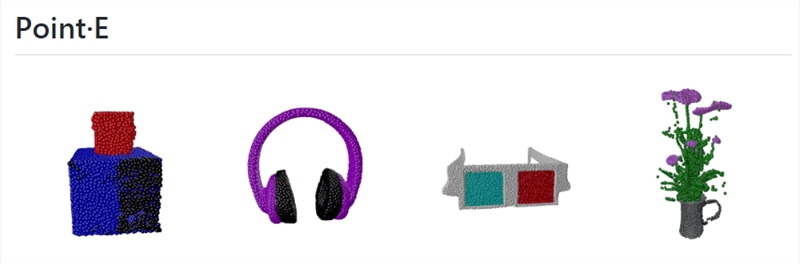

DALL-E2可以说是2022年最热门AI绘画模型之一,最近 OpenAI 刚刚发布一个功能似乎更为强大AI模型,可用于3D建模。

在12月16日提交的一篇论文中,OpenAI 团队描述Point-E称,这是一种从复杂的文本提示生成3D 点云的方法。

利用Point-E,AI 爱好者可以跳过文本生成2D 图像的阶段,用文本生成3D模型。该项目也已在Github上开源,以及模型的各种参数数量的权重。

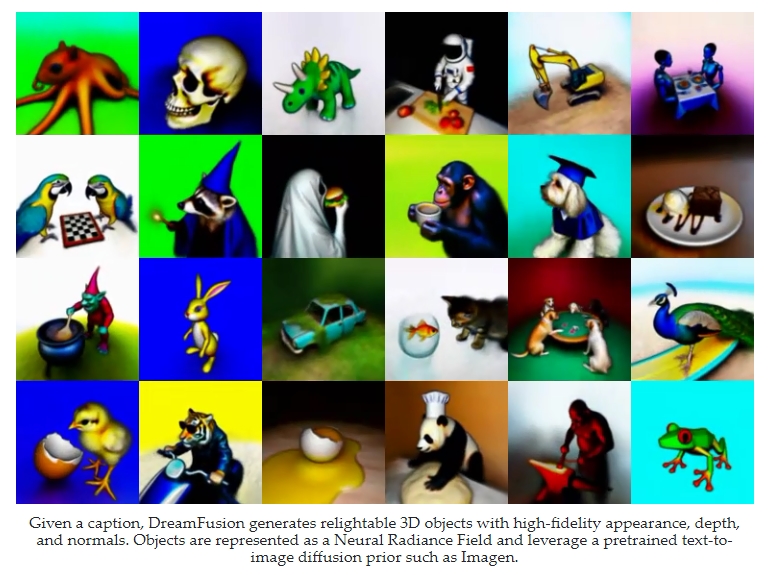

该模型只是使解决方案起作用的部分之一。论文的关键在于提出的通过适用于点云的扩散方法创建3D 对象的方法。该算法的创建重点是虚拟现实、游戏和工业设计,因为它生成3D 对象的速度比当前方法快600倍。

文本生成3D 模型目前有两种工作方式。第一种是在具有3D 对象到文本配对的数据上训练生成模型。这导致无法理解更复杂的提示以及3D数据集的问题。第二种方法是利用文本图像模型来优化提示的3D 表示的创建。

Point-E 结合了传统的文本到3D 合成训练算法的方法。将两个单独的模型结合在一起,Point-E 可以减少创建3D 对象的数量。第一组算法是文本到图像模型,类似 DALL-E2,它可以创建用户给出的提示的图像。然后将此图像用作第二个模型的基础,该模型将图像转换为3D对象。

OpenAI 团队创建了一个包含数百万个3D 模型的数据集,再通过 Blender 将其导出。然后对这些渲染进行处理,将图像数据提取为点云,这是表示3D物体合成密度的一种方式。经过进一步的处理,比如删除平面对象和通过CLIP特征进行聚类,数据集就可以被输入View Synthesis GLIDE模型了。

接着,研究人员通过将点云表示为形状的张量,创建了一种新的点云扩散方法。然后,通过逐步去噪,将这些张量从随机形状削减到所需3D对象的形状。该扩散模型的输出通过点云上采样器运行,以提高最终输出的质量。为了与常见的3D 应用程序兼容,使用 Blender 将点云转换为网格。

最后,这些网格可用于游戏、元宇宙应用程序或其他3D 密集型任务,如电影后期处理。虽然 DALL-E 已经彻底改变了文本到图像的生成过程,但 Point-E 的目标是为3D 领域做同样的事情。

Point-E的Github开源网址:https://github.com/openai/point-e